Dunia bisnis modern kini semakin bergantung pada data, dan di sinilah peran krusial dari Machine learning pipeline yang efektif untuk prediksi churn dan mengidentifikasi potensi upsell bagi pelanggan. Bayangkan, dengan kemampuan memprediksi pelanggan yang berpotensi berhenti berlangganan, perusahaan dapat mengambil tindakan preventif. Lebih jauh lagi, dengan mengidentifikasi peluang upsell yang tepat, pendapatan dapat ditingkatkan secara signifikan.

Artikel ini akan mengupas tuntas bagaimana membangun dan mengimplementasikan machine learning pipeline untuk mencapai tujuan tersebut. Mulai dari pengumpulan dan persiapan data, pemilihan model yang tepat, evaluasi dan optimasi kinerja, hingga deployment dan monitoring. Kita juga akan membahas strategi upsell yang dipersonalisasi, serta studi kasus nyata yang memberikan gambaran konkret tentang keberhasilan implementasi. Mari selami dunia yang menarik ini!

Pengantar Machine Learning Pipeline untuk Prediksi Churn dan Upselling

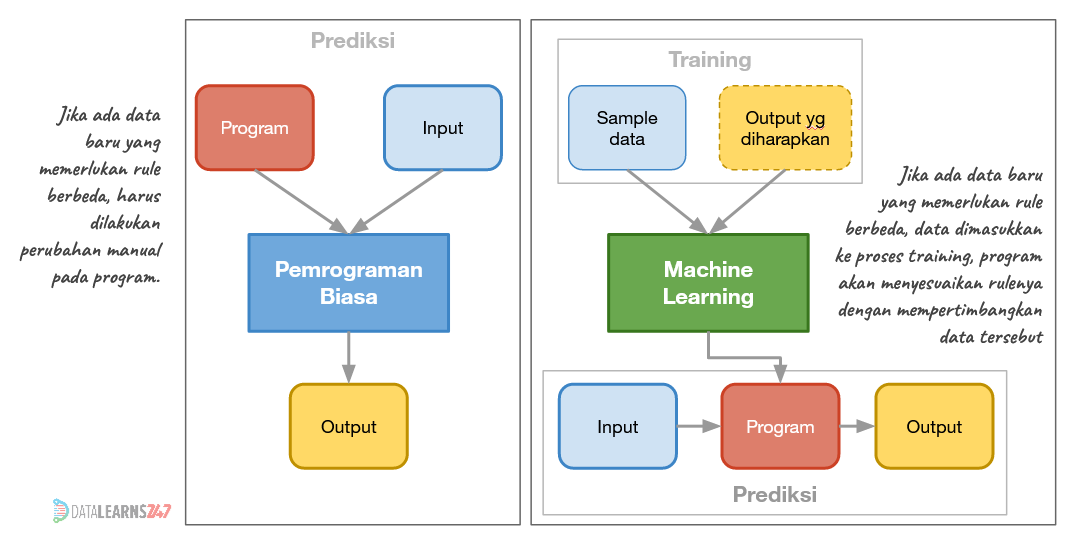

Machine learning (ML) pipeline adalah serangkaian tahapan yang terstruktur dan otomatis untuk membangun, melatih, mengevaluasi, dan menyebarkan model machine learning. Dalam konteks bisnis, pipeline ini sangat penting karena memungkinkan organisasi untuk memanfaatkan data secara efektif, membuat keputusan yang lebih cerdas, dan mencapai tujuan bisnis yang spesifik. Artikel ini akan membahas bagaimana ML pipeline dapat digunakan untuk memprediksi churn pelanggan dan mengidentifikasi peluang upsell, serta tantangan yang mungkin dihadapi dalam implementasinya.

Prediksi churn dan identifikasi upsell adalah dua area krusial yang dapat dioptimalkan dengan ML pipeline. Dengan memanfaatkan data pelanggan, pipeline dapat membantu bisnis untuk memahami perilaku pelanggan, memprediksi kemungkinan churn, dan menawarkan produk atau layanan tambahan yang relevan.

Manfaat Prediksi Churn Menggunakan Machine Learning

Prediksi churn dengan machine learning menawarkan sejumlah manfaat signifikan bagi bisnis. Kemampuan untuk memprediksi pelanggan yang berisiko meninggalkan layanan memungkinkan perusahaan untuk mengambil tindakan preventif yang tepat waktu.

- Pengurangan Tingkat Churn: Dengan mengidentifikasi pelanggan yang berisiko churn, perusahaan dapat menawarkan insentif, diskon, atau layanan tambahan untuk mempertahankan mereka. Contohnya, sebuah perusahaan telekomunikasi dapat menawarkan paket khusus kepada pelanggan yang diprediksi akan beralih ke pesaing.

- Peningkatan Retensi Pelanggan: Melalui intervensi yang tepat, perusahaan dapat meningkatkan loyalitas pelanggan dan memperpanjang masa pakai mereka. Sebuah platform streaming musik, misalnya, dapat menawarkan rekomendasi musik yang dipersonalisasi atau fitur eksklusif untuk mencegah pelanggan membatalkan langganan.

- Penghematan Biaya: Lebih murah untuk mempertahankan pelanggan yang ada daripada memperoleh pelanggan baru. Prediksi churn memungkinkan perusahaan untuk memfokuskan sumber daya pada pelanggan yang paling mungkin untuk churn, memaksimalkan efisiensi biaya.

- Peningkatan Kepuasan Pelanggan: Dengan memahami alasan di balik potensi churn, perusahaan dapat memperbaiki layanan, produk, atau pengalaman pelanggan secara keseluruhan, yang pada akhirnya meningkatkan kepuasan pelanggan.

Skenario Bisnis untuk Upselling dengan Machine Learning Pipeline

Machine learning pipeline dapat secara efektif digunakan untuk mengidentifikasi peluang upsell. Mari kita ambil contoh sebuah perusahaan e-commerce yang menjual berbagai produk elektronik.

Skenario: Seorang pelanggan membeli sebuah laptop. ML pipeline dapat menganalisis data pembelian sebelumnya, riwayat penelusuran, dan demografi pelanggan untuk mengidentifikasi peluang upsell. Pipeline dapat merekomendasikan produk tambahan seperti perangkat lunak antivirus premium, garansi tambahan, atau aksesoris seperti tas laptop dan mouse nirkabel.

- Analisis Data: Pipeline mengumpulkan dan menganalisis data dari berbagai sumber, termasuk data pembelian, riwayat penelusuran, demografi pelanggan, dan data interaksi pelanggan.

- Pemodelan: Model machine learning dilatih untuk memprediksi produk atau layanan mana yang kemungkinan besar akan dibeli oleh pelanggan berdasarkan profil mereka. Model ini dapat menggunakan algoritma seperti sistem rekomendasi berbasis kolaborasi atau sistem rekomendasi berbasis konten.

- Personalisasi: Rekomendasi upsell dipersonalisasi untuk setiap pelanggan berdasarkan hasil prediksi model.

- Implementasi: Rekomendasi ditampilkan kepada pelanggan melalui berbagai saluran, seperti situs web, email, atau aplikasi seluler.

- Evaluasi: Kinerja pipeline dievaluasi secara berkala dengan memantau tingkat konversi upsell, pendapatan tambahan, dan kepuasan pelanggan.

Tantangan dalam Membangun dan Mengelola Machine Learning Pipeline

Membangun dan mengelola machine learning pipeline bukanlah tugas yang mudah. Ada beberapa tantangan umum yang perlu diatasi untuk memastikan keberhasilan proyek.

- Kualitas Data: Kualitas data yang buruk dapat menyebabkan model yang tidak akurat. Penting untuk memastikan data yang digunakan dalam pipeline bersih, konsisten, dan relevan.

- Integrasi Data: Mengintegrasikan data dari berbagai sumber dapat menjadi tantangan, terutama jika sumber data memiliki format atau struktur yang berbeda.

- Pemilihan Model: Memilih model machine learning yang tepat untuk masalah tertentu memerlukan pemahaman yang mendalam tentang berbagai algoritma dan data.

- Pelatihan dan Evaluasi Model: Melatih dan mengevaluasi model memerlukan sumber daya komputasi yang signifikan dan pengetahuan tentang teknik evaluasi model.

- Automasi: Otomatisasi seluruh pipeline, dari pengumpulan data hingga penyebaran model, dapat menjadi kompleks dan memerlukan alat dan infrastruktur yang tepat.

- Pemantauan dan Pemeliharaan: Model machine learning perlu dipantau secara berkala untuk memastikan kinerjanya tetap optimal. Model juga perlu diperbarui dan dilatih ulang secara berkala untuk memperhitungkan perubahan dalam data.

Peran dalam Proyek Machine Learning Pipeline

Proyek machine learning pipeline melibatkan berbagai pemangku kepentingan dengan peran dan tanggung jawab yang berbeda.

- Data Scientist: Bertanggung jawab untuk merancang, membangun, melatih, dan mengevaluasi model machine learning. Mereka juga bertanggung jawab untuk menganalisis data, melakukan eksplorasi data, dan memilih algoritma yang tepat.

- Machine Learning Engineer: Bertanggung jawab untuk membangun dan memelihara infrastruktur machine learning, termasuk pipeline data, alat pelatihan model, dan layanan penyebaran model. Mereka juga bertanggung jawab untuk mengotomatisasi proses dan memastikan skalabilitas dan keandalan pipeline.

- Data Engineer: Bertanggung jawab untuk mengumpulkan, membersihkan, dan mengintegrasikan data dari berbagai sumber. Mereka juga bertanggung jawab untuk membangun dan memelihara gudang data dan pipeline data.

- Pemilik Produk/Manajer Bisnis: Bertanggung jawab untuk mendefinisikan tujuan bisnis, mengidentifikasi kasus penggunaan, dan mengelola proyek secara keseluruhan. Mereka juga bertanggung jawab untuk berkomunikasi dengan pemangku kepentingan lainnya dan memastikan bahwa proyek selaras dengan tujuan bisnis.

- Pengembang Perangkat Lunak: Bertanggung jawab untuk mengintegrasikan model machine learning ke dalam aplikasi dan layanan yang ada. Mereka juga bertanggung jawab untuk membangun antarmuka pengguna dan memastikan bahwa model dapat diakses oleh pengguna akhir.

- Pemangku Kepentingan Lainnya: Pemangku kepentingan lainnya dapat mencakup ahli domain, analis bisnis, dan perwakilan dari berbagai departemen seperti pemasaran, penjualan, dan layanan pelanggan. Mereka memberikan masukan tentang data, kebutuhan bisnis, dan persyaratan implementasi.

Tahapan Machine Learning Pipeline

Setelah memahami konsep dasar machine learning pipeline untuk prediksi churn dan upselling, langkah krusial berikutnya adalah membangun fondasi yang kokoh melalui pengumpulan dan persiapan data. Kualitas data yang baik adalah kunci keberhasilan model, oleh karena itu, tahapan ini memerlukan perhatian khusus untuk memastikan data yang digunakan akurat, lengkap, dan siap untuk dianalisis.

Pengumpulan dan Persiapan Data

Proses ini melibatkan beberapa langkah penting yang memastikan data siap digunakan untuk membangun model yang efektif. Mulai dari pengumpulan data dari berbagai sumber, pembersihan data, penanganan nilai yang hilang dan outlier, hingga rekayasa fitur. Semua tahapan ini saling terkait dan berkontribusi pada kualitas akhir model.

Sumber Data Potensial

Pengumpulan data yang komprehensif adalah fondasi utama dalam membangun model yang akurat. Data yang relevan dapat diperoleh dari berbagai sumber, baik internal maupun eksternal. Berikut adalah beberapa sumber data potensial yang dapat digunakan:

- Data Pelanggan: Informasi demografis (usia, jenis kelamin, lokasi), riwayat pembelian, preferensi produk, dan data kontak. Sumber: CRM (Customer Relationship Management), database pelanggan.

- Data Penggunaan Produk/Layanan: Frekuensi penggunaan layanan, fitur yang digunakan, durasi penggunaan, dan interaksi dengan produk. Sumber: Log aplikasi, data penggunaan platform.

- Data Transaksi: Riwayat transaksi, nilai transaksi, frekuensi pembelian, dan produk yang dibeli. Sumber: Sistem POS (Point of Sale), database transaksi.

- Data Interaksi Pelanggan: Interaksi dengan layanan pelanggan (panggilan, email, chat), umpan balik pelanggan, dan keluhan. Sumber: Sistem tiket, platform umpan balik pelanggan.

- Data Pemasaran: Respons terhadap kampanye pemasaran, klik pada iklan, dan konversi. Sumber: Platform pemasaran digital, data analitik website.

- Data Eksternal: Data dari pihak ketiga seperti data cuaca, data ekonomi, atau data demografis regional. Sumber: API data eksternal, lembaga statistik.

Teknik Pra-Pemrosesan Data, Machine learning pipeline yang efektif untuk prediksi churn dan mengidentifikasi potensi upsell bagi pelanggan.

Setelah data dikumpulkan, langkah selanjutnya adalah melakukan pra-pemrosesan. Tujuannya adalah untuk membersihkan, mengubah, dan mempersiapkan data agar sesuai dengan kebutuhan model. Teknik pra-pemrosesan yang penting meliputi:

- Pembersihan Data (Data Cleaning): Menghilangkan duplikasi data, memperbaiki kesalahan penulisan, dan menangani nilai yang tidak konsisten.

- Transformasi Data (Data Transformation): Mengubah format data (misalnya, konversi tipe data), melakukan penskalaan (scaling) atau normalisasi (normalization) untuk menyamakan skala fitur.

- Reduksi Dimensi (Dimensionality Reduction): Mengurangi jumlah fitur untuk menghindari curse of dimensionality dan meningkatkan efisiensi model (misalnya, menggunakan PCA – Principal Component Analysis).

- Encoding Variabel Kategori (Categorical Encoding): Mengubah variabel kategori (misalnya, jenis kelamin, status pernikahan) menjadi format numerik yang dapat diproses oleh model (misalnya, menggunakan One-Hot Encoding atau Label Encoding).

Penanganan Missing Values dan Outliers

Missing values (nilai yang hilang) dan outliers (nilai yang ekstrem) dapat mempengaruhi kinerja model. Oleh karena itu, penanganan yang tepat sangat penting. Strategi yang umum digunakan adalah:

- Penanganan Missing Values:

- Imputasi (Imputation): Mengisi nilai yang hilang dengan nilai tertentu, seperti rata-rata (mean), median, modus, atau nilai konstan.

- Penghapusan (Deletion): Menghapus baris data yang mengandung nilai yang hilang (jika jumlah missing values sedikit).

- Model-Based Imputation: Menggunakan model machine learning untuk memprediksi nilai yang hilang.

- Penanganan Outliers:

- Penghapusan (Deletion): Menghapus outlier (jika outlier dianggap sebagai kesalahan data).

- Transformasi (Transformation): Mengubah nilai outlier dengan transformasi logaritmik atau capping.

- Winsorizing: Mengganti nilai outlier dengan nilai tertentu (misalnya, nilai persentil ke-95).

Contoh Kode (Pseudo-Code) untuk Data Cleaning dan Transformasi

Berikut adalah contoh pseudo-code yang menggambarkan proses data cleaning dan transformasi menggunakan library populer seperti Pandas dan Scikit-learn dalam Python:

# Impor library

import pandas as pd

from sklearn.impute import SimpleImputer

from sklearn.preprocessing import StandardScaler, OneHotEncoder

# Membaca data

data = pd.read_csv('data_pelanggan.csv')

# Penanganan Missing Values (Imputasi)

imputer_mean = SimpleImputer(strategy='mean')

data['usia'] = imputer_mean.fit_transform(data[['usia']])

# Penanganan Outliers (Capping)

Q1 = data['nilai_transaksi'].quantile(0.25)

Q3 = data['nilai_transaksi'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

data['nilai_transaksi'] = data['nilai_transaksi'].clip(lower_bound, upper_bound)

# Transformasi Data (Scaling)

scaler = StandardScaler()

data[['jumlah_pembelian', 'durasi_penggunaan']] = scaler.fit_transform(data[['jumlah_pembelian', 'durasi_penggunaan']])

# Encoding Variabel Kategori

encoder = OneHotEncoder(handle_unknown='ignore')

encoded_data = encoder.fit_transform(data[['jenis_kelamin', 'status_perkawinan']]).toarray()

encoded_df = pd.DataFrame(encoded_data, columns=encoder.get_feature_names_out(['jenis_kelamin', 'status_perkawinan']))

data = pd.concat([data.reset_index(drop=True), encoded_df.reset_index(drop=True)], axis=1)

data = data.drop(columns=['jenis_kelamin', 'status_perkawinan'])

# Tampilkan beberapa baris data yang sudah diproses

print(data.head())

Kode di atas menunjukkan bagaimana menangani missing values dengan imputasi rata-rata, menangani outlier dengan capping, melakukan scaling menggunakan StandardScaler, dan melakukan One-Hot Encoding pada variabel kategori.

Feature Engineering yang Efektif

Feature engineering adalah proses membuat fitur baru dari fitur yang sudah ada untuk meningkatkan kinerja model. Berikut adalah beberapa tips untuk melakukan feature engineering yang efektif:

- Buat Fitur Berdasarkan Waktu:

- Durasi: Hitung durasi berlangganan, durasi penggunaan produk, atau selisih waktu antara pembelian.

- Frekuensi: Hitung frekuensi pembelian, frekuensi penggunaan layanan, atau frekuensi interaksi dengan layanan pelanggan.

- Tren: Buat fitur yang mencerminkan tren, seperti pertumbuhan penjualan atau penurunan penggunaan layanan.

- Gabungkan Fitur:

- Rasio: Buat rasio antara dua fitur, seperti rasio nilai transaksi terhadap jumlah pembelian (rata-rata nilai transaksi).

- Interaksi: Buat fitur interaksi antara dua atau lebih fitur, seperti interaksi antara usia dan durasi berlangganan.

- Gunakan Informasi Domain:

- Segmentasi Pelanggan: Segmentasi pelanggan berdasarkan perilaku, demografi, atau preferensi.

- Analisis Sentimen: Gunakan analisis sentimen untuk mengukur sentimen pelanggan dari umpan balik atau interaksi.

- Contoh Feature Engineering untuk Prediksi Churn:

- Lifetime Value (LTV): Perkirakan nilai pelanggan selama masa hidupnya. Pelanggan dengan LTV rendah lebih berisiko churn.

- Jumlah Tiket Dukungan: Jumlah tiket dukungan yang dibuka oleh pelanggan. Pelanggan dengan jumlah tiket yang tinggi mungkin mengalami masalah dengan layanan.

- Penurunan Penggunaan: Persentase penurunan penggunaan layanan dalam periode tertentu. Penurunan penggunaan adalah indikator kuat dari potensi churn.

- Contoh Feature Engineering untuk Upselling:

- Nilai Transaksi Rata-Rata: Nilai transaksi rata-rata pelanggan. Pelanggan dengan nilai transaksi yang tinggi lebih mungkin untuk di-upsell.

- Jumlah Produk yang Dibeli: Jumlah produk yang dibeli oleh pelanggan. Pelanggan yang membeli banyak produk mungkin tertarik pada produk tambahan.

- Interaksi dengan Fitur Premium: Seberapa sering pelanggan menggunakan fitur premium. Pelanggan yang sering menggunakan fitur premium mungkin bersedia membayar lebih untuk fitur tambahan.

Pemilihan Model dan Pelatihan

Proses pemilihan model dan pelatihan merupakan jantung dari machine learning pipeline. Keputusan yang tepat pada tahap ini akan sangat memengaruhi akurasi prediksi churn dan efektivitas rekomendasi upsell. Pemilihan model yang bijak, pelatihan yang optimal, dan validasi yang komprehensif akan menghasilkan model yang mampu memberikan nilai bisnis yang signifikan.

Mari kita telaah lebih dalam tentang bagaimana memilih dan melatih model machine learning untuk mencapai tujuan tersebut.

Jenis Model Machine Learning untuk Prediksi Churn dan Upsell

Terdapat berbagai jenis model machine learning yang dapat digunakan untuk prediksi churn dan upsell. Setiap model memiliki kelebihan dan kekurangan yang perlu dipertimbangkan berdasarkan karakteristik data dan kebutuhan bisnis. Berikut adalah beberapa model yang umum digunakan:

- Regresi Logistik: Model ini sangat cocok untuk prediksi churn karena memberikan probabilitas pelanggan akan berhenti berlangganan. Kelebihannya adalah interpretasinya yang mudah dan efisiensi komputasinya. Namun, kekurangannya adalah asumsi linearitas yang mungkin tidak selalu terpenuhi dalam data dunia nyata.

- Pohon Keputusan: Model ini mampu menangani data non-linear dan memberikan interpretasi yang mudah melalui visualisasi pohon. Kelebihannya adalah kemampuannya menangani data kategorikal dan numerik secara bersamaan. Kekurangannya adalah rentan terhadap overfitting, terutama jika pohon tumbuh terlalu dalam.

- Random Forest: Model ini merupakan ansambel dari banyak pohon keputusan, sehingga mampu mengurangi overfitting dan meningkatkan akurasi. Kelebihannya adalah ketahanan terhadap noise dan kemampuan untuk mengukur pentingnya fitur. Kekurangannya adalah kompleksitas interpretasi yang lebih tinggi dibandingkan pohon keputusan tunggal.

- Gradient Boosting Machines (GBM): Model ini juga merupakan teknik ansambel yang membangun model secara berurutan, dengan setiap model memperbaiki kesalahan model sebelumnya. Kelebihannya adalah akurasi yang tinggi dan kemampuan untuk menangani data yang hilang. Kekurangannya adalah sensitivitas terhadap hyperparameter dan waktu pelatihan yang lebih lama. Contohnya adalah XGBoost dan LightGBM.

- Support Vector Machines (SVM): Model ini efektif dalam memisahkan data menggunakan hyperplane. Kelebihannya adalah efektif dalam ruang dimensi tinggi dan mampu menangani data non-linear melalui penggunaan kernel. Kekurangannya adalah sensitivitas terhadap hyperparameter dan waktu pelatihan yang lebih lama, terutama pada dataset yang besar.

- Jaringan Saraf Tiruan (Neural Networks): Model ini sangat fleksibel dan mampu mempelajari pola yang kompleks dalam data. Kelebihannya adalah kemampuannya menangani data yang sangat kompleks dan menghasilkan prediksi yang sangat akurat. Kekurangannya adalah membutuhkan data dalam jumlah besar, waktu pelatihan yang lama, dan interpretasi yang sulit.

Kriteria Pemilihan Model Terbaik

Pemilihan model terbaik harus didasarkan pada kebutuhan bisnis dan karakteristik data. Beberapa kriteria yang perlu dipertimbangkan adalah:

- Akurasi: Seberapa akurat model dalam memprediksi churn atau mengidentifikasi peluang upsell.

- Interpretasi: Seberapa mudah model untuk dipahami dan dijelaskan kepada pemangku kepentingan bisnis.

- Waktu Pelatihan: Berapa lama waktu yang dibutuhkan untuk melatih model.

- Waktu Prediksi: Berapa lama waktu yang dibutuhkan model untuk membuat prediksi.

- Ketersediaan Data: Apakah data yang dibutuhkan untuk melatih model tersedia dan lengkap.

- Sumber Daya: Apakah sumber daya komputasi yang dibutuhkan untuk melatih dan menjalankan model tersedia.

Sebagai contoh, jika interpretasi model sangat penting (misalnya, untuk memahami faktor-faktor yang mendorong churn), maka model seperti regresi logistik atau pohon keputusan mungkin lebih cocok daripada model yang lebih kompleks seperti jaringan saraf tiruan.

Langkah-langkah Pelatihan Model

Pelatihan model melibatkan beberapa langkah penting untuk memastikan model dapat bekerja secara optimal:

- Pemilihan Hyperparameter: Hyperparameter adalah parameter yang diatur sebelum pelatihan model dimulai. Pemilihan hyperparameter yang tepat sangat penting untuk kinerja model. Teknik seperti grid search, random search, dan bayesian optimization dapat digunakan untuk menemukan kombinasi hyperparameter terbaik.

- Pembagian Data: Data dibagi menjadi tiga bagian: data pelatihan, data validasi, dan data pengujian. Data pelatihan digunakan untuk melatih model, data validasi digunakan untuk memilih hyperparameter, dan data pengujian digunakan untuk mengukur kinerja akhir model.

- Pelatihan Model: Model dilatih menggunakan data pelatihan. Proses pelatihan melibatkan penyesuaian parameter model untuk meminimalkan fungsi kerugian (loss function).

- Validasi Model: Model dievaluasi menggunakan data validasi untuk mengukur kinerjanya dan menyesuaikan hyperparameter jika diperlukan.

- Pengujian Model: Model diuji menggunakan data pengujian untuk mengukur kinerja akhir model dan memastikan model dapat digeneralisasi dengan baik pada data yang belum pernah dilihat sebelumnya.

Penggunaan Cross-Validation

Cross-validation adalah teknik yang digunakan untuk mengukur kinerja model secara lebih akurat dan mengurangi bias. Dalam cross-validation, data dibagi menjadi beberapa bagian (fold). Model dilatih dan diuji beberapa kali, dengan setiap fold digunakan sebagai data pengujian sekali. Hasil dari setiap iterasi kemudian dirata-ratakan untuk mendapatkan estimasi kinerja model yang lebih stabil.

Sebagai contoh, k-fold cross-validation membagi data menjadi k bagian. Model dilatih pada k-1 bagian dan diuji pada bagian yang tersisa. Proses ini diulang sebanyak k kali, dengan setiap bagian digunakan sebagai data pengujian sekali. Hasil dari setiap iterasi kemudian dirata-ratakan.

Perbandingan Performa Model

Berikut adalah contoh tabel yang membandingkan performa beberapa model yang berbeda menggunakan metrik evaluasi yang relevan:

| Model | Akurasi | Presisi | Recall | F1-score |

|---|---|---|---|---|

| Regresi Logistik | 0.78 | 0.75 | 0.70 | 0.72 |

| Pohon Keputusan | 0.75 | 0.70 | 0.72 | 0.71 |

| Random Forest | 0.82 | 0.80 | 0.78 | 0.79 |

| Gradient Boosting (XGBoost) | 0.85 | 0.83 | 0.81 | 0.82 |

Tabel di atas menunjukkan bahwa Gradient Boosting (XGBoost) memberikan performa terbaik berdasarkan metrik evaluasi yang digunakan. Namun, pemilihan model terbaik harus mempertimbangkan faktor-faktor lain seperti interpretasi dan waktu pelatihan.

Evaluasi dan Optimasi Model

Setelah model machine learning (ML) untuk prediksi churn dan upsell dilatih, langkah krusial berikutnya adalah mengevaluasi kinerjanya dan melakukan optimasi. Proses ini memastikan model memberikan hasil yang akurat dan dapat diandalkan. Evaluasi yang cermat memungkinkan kita mengidentifikasi kelemahan model dan melakukan perbaikan yang diperlukan untuk mencapai performa optimal.

Metrik Evaluasi Kinerja Model

Evaluasi model melibatkan penggunaan berbagai metrik untuk mengukur seberapa baik model memprediksi churn dan potensi upsell. Pemilihan metrik yang tepat sangat penting karena akan memberikan gambaran yang komprehensif tentang kinerja model. Beberapa metrik evaluasi yang umum digunakan adalah:

- AUC-ROC (Area Under the Receiver Operating Characteristic Curve): Metrik ini mengukur kemampuan model untuk membedakan antara kelas yang berbeda (misalnya, pelanggan yang akan churn dan yang tidak). Nilai AUC-ROC berkisar antara 0 dan 1, dengan nilai yang lebih tinggi menunjukkan kinerja yang lebih baik. AUC-ROC sangat berguna karena tidak terpengaruh oleh class imbalance (ketidakseimbangan kelas).

- Precision (Presisi): Metrik ini mengukur proporsi prediksi positif yang benar dari semua prediksi positif yang dibuat oleh model. Precision sangat penting untuk meminimalkan kesalahan positif palsu (false positive). Misalnya, dalam prediksi churn, precision membantu meminimalkan jumlah pelanggan yang salah diprediksi akan churn.

- Recall (Recall): Metrik ini mengukur proporsi prediksi positif yang benar dari semua kasus positif yang sebenarnya. Recall penting untuk meminimalkan kesalahan negatif palsu (false negative). Dalam konteks prediksi churn, recall membantu mengidentifikasi sebanyak mungkin pelanggan yang benar-benar akan churn.

- F1-score: F1-score adalah rata-rata harmonik dari precision dan recall. Metrik ini memberikan keseimbangan antara precision dan recall, sehingga sangat berguna ketika terdapat ketidakseimbangan kelas. F1-score memberikan gambaran yang lebih komprehensif tentang kinerja model dibandingkan hanya menggunakan precision atau recall saja.

Mengatasi Overfitting dan Underfitting

Overfitting dan underfitting adalah dua masalah umum yang dapat mempengaruhi kinerja model ML. Overfitting terjadi ketika model terlalu kompleks dan mempelajari pola dalam data pelatihan yang tidak ada dalam data baru, sehingga model berkinerja buruk pada data baru. Underfitting terjadi ketika model terlalu sederhana dan tidak mampu menangkap pola kompleks dalam data pelatihan.

Berikut adalah cara untuk mengatasi kedua masalah tersebut:

- Mengatasi Overfitting:

- Pengumpulan Data Tambahan: Menambah jumlah data pelatihan dapat membantu model belajar pola yang lebih umum dan mengurangi overfitting.

- Penyederhanaan Model: Mengurangi kompleksitas model, misalnya dengan mengurangi jumlah lapisan dalam jaringan saraf atau menggunakan model yang lebih sederhana.

- Regularisasi: Menambahkan penalti ke fungsi kerugian untuk mencegah koefisien model menjadi terlalu besar. Contohnya adalah regularisasi L1 dan L2.

- Dropout: Dalam jaringan saraf, dropout secara acak menonaktifkan sebagian neuron selama pelatihan, yang membantu mencegah model bergantung pada neuron tertentu.

- Mengatasi Underfitting:

- Peningkatan Kompleksitas Model: Meningkatkan kompleksitas model, misalnya dengan menambahkan lebih banyak lapisan atau neuron.

- Fitur Tambahan: Menambahkan fitur baru yang relevan dapat membantu model mempelajari pola yang lebih kompleks.

- Pelatihan Lebih Lama: Melatih model lebih lama dapat memberikan waktu bagi model untuk belajar dari data.

Hyperparameter Tuning

Hyperparameter tuning adalah proses menemukan kombinasi nilai hyperparameter terbaik untuk model ML. Hyperparameter adalah parameter yang tidak dipelajari oleh model dari data, tetapi harus diatur sebelum pelatihan. Hyperparameter tuning sangat penting untuk meningkatkan kinerja model. Beberapa metode umum untuk hyperparameter tuning adalah:

- Grid Search: Metode ini mencoba semua kombinasi nilai hyperparameter yang telah ditentukan.

- Random Search: Metode ini secara acak memilih kombinasi nilai hyperparameter dari distribusi yang telah ditentukan.

- Bayesian Optimization: Metode ini menggunakan model probabilitas untuk memprediksi kinerja model untuk kombinasi hyperparameter yang berbeda.

Ensemble Learning

Ensemble learning adalah teknik yang menggabungkan beberapa model ML untuk membuat prediksi yang lebih akurat. Ide dasarnya adalah bahwa dengan menggabungkan kekuatan dari beberapa model, kita dapat mengurangi bias dan varians dari prediksi individu. Beberapa teknik ensemble learning yang populer adalah:

- Bagging (Bootstrap Aggregating): Melatih beberapa model pada subset data pelatihan yang berbeda (dengan penggantian).

- Boosting: Melatih model secara berurutan, di mana setiap model mencoba untuk memperbaiki kesalahan dari model sebelumnya.

- Stacking: Menggabungkan prediksi dari beberapa model menggunakan model meta-learner.

Visualisasi Hasil Evaluasi Model

Visualisasi sangat penting untuk memahami kinerja model dan mengkomunikasikan hasilnya. Berikut adalah contoh visualisasi yang dapat digunakan untuk menggambarkan hasil evaluasi model:

- Kurva ROC (Receiver Operating Characteristic): Kurva ini memplot True Positive Rate (TPR) terhadap False Positive Rate (FPR) pada berbagai ambang batas klasifikasi. AUC-ROC dapat dihitung dari kurva ini.

- Confusion Matrix: Matriks ini menampilkan jumlah prediksi benar dan salah untuk setiap kelas.

- Bar Chart: Diagram batang dapat digunakan untuk membandingkan metrik evaluasi (precision, recall, F1-score) untuk berbagai model atau kombinasi hyperparameter.

- Scatter Plot: Scatter plot dapat digunakan untuk memvisualisasikan prediksi model terhadap nilai sebenarnya.

Sebagai contoh, berikut adalah deskripsi visualisasi confusion matrix untuk model prediksi churn:

Confusion matrix akan menampilkan empat kuadran. Kuadran pertama (kiri atas) menunjukkan jumlah pelanggan yang diprediksi tidak akan churn dan memang tidak churn (True Negative). Kuadran kedua (kanan atas) menunjukkan jumlah pelanggan yang diprediksi akan churn padahal sebenarnya tidak (False Positive). Kuadran ketiga (kiri bawah) menunjukkan jumlah pelanggan yang diprediksi tidak akan churn padahal sebenarnya akan (False Negative). Kuadran keempat (kanan bawah) menunjukkan jumlah pelanggan yang diprediksi akan churn dan memang akan (True Positive). Visualisasi ini memberikan gambaran yang jelas tentang jenis kesalahan yang dibuat oleh model.

Deployment dan Monitoring

Setelah model machine learning (ML) selesai dibangun, dilatih, dan dievaluasi, langkah krusial berikutnya adalah melakukan deployment dan memantau kinerjanya di lingkungan produksi. Proses ini memastikan model dapat memberikan prediksi secara real-time atau terjadwal, serta memastikan model tetap relevan dan akurat seiring waktu. Kegagalan dalam tahap ini dapat mengakibatkan model memberikan hasil yang salah, merugikan bisnis, dan mengurangi kepercayaan pelanggan. Oleh karena itu, pemahaman mendalam tentang metode deployment, strategi monitoring, dan penanganan masalah model sangat penting.

Metode Deployment Model Machine Learning

Terdapat beberapa metode untuk melakukan deployment model ML, masing-masing dengan kelebihan dan kekurangannya. Pemilihan metode yang tepat bergantung pada kebutuhan bisnis, volume data, persyaratan latency, dan infrastruktur yang tersedia.

- API (Application Programming Interface): Metode ini melibatkan pembuatan API yang memungkinkan aplikasi lain berinteraksi dengan model. Model di-deploy pada server dan API menyediakan endpoint untuk menerima permintaan prediksi. Keuntungannya adalah fleksibilitas dan integrasi mudah dengan sistem yang ada. Contohnya, model prediksi churn dapat diintegrasikan dengan sistem CRM melalui API untuk memberikan skor risiko churn secara real-time.

- Batch Prediction: Metode ini cocok untuk prediksi yang tidak memerlukan real-time. Model dijalankan secara berkala (misalnya, setiap hari atau minggu) pada kumpulan data yang besar. Hasil prediksi disimpan dalam basis data atau sistem penyimpanan lainnya. Cocok untuk analisis laporan atau segmentasi pelanggan.

- Real-time Prediction: Metode ini ideal untuk aplikasi yang membutuhkan prediksi instan. Model di-deploy pada infrastruktur yang mampu menangani permintaan secara cepat, seperti server dengan sumber daya tinggi atau platform edge computing. Digunakan untuk aplikasi seperti rekomendasi produk atau deteksi penipuan.

Monitoring Kinerja Model Setelah Deployment

Setelah model di-deploy, monitoring kinerja menjadi krusial untuk memastikan model tetap akurat dan relevan. Monitoring melibatkan pengumpulan dan analisis data untuk mengidentifikasi potensi masalah, seperti penurunan akurasi atau perubahan perilaku pelanggan.

- Metrik Kinerja: Pantau metrik kinerja model secara berkala, seperti akurasi, presisi, recall, dan skor F1. Bandingkan metrik ini dengan baseline yang ditetapkan selama evaluasi model.

- Data Drift: Lacak perubahan distribusi data input. Data drift terjadi ketika distribusi data yang digunakan untuk melatih model berbeda dengan distribusi data yang diterima model saat produksi. Gunakan teknik seperti Kolmogorov-Smirnov test atau Jensen-Shannon divergence untuk mendeteksi data drift.

- Concept Drift: Pantau perubahan hubungan antara input dan output. Concept drift terjadi ketika hubungan antara fitur dan target berubah seiring waktu.

- Log Prediksi: Simpan log semua prediksi yang dibuat oleh model, termasuk input, output, dan informasi kontekstual lainnya. Log ini berguna untuk analisis lebih lanjut dan debugging.

- Alerting: Atur alert untuk memberi tahu tim ketika metrik kinerja model menurun atau ketika data drift terdeteksi.

Menjaga Model Tetap Relevan dengan Data Baru dan Perubahan Perilaku Pelanggan

Dunia bisnis dinamis, dan perilaku pelanggan terus berubah. Untuk menjaga model tetap relevan, diperlukan strategi yang proaktif untuk beradaptasi dengan data baru dan perubahan perilaku pelanggan.

- Pengumpulan Data Berkelanjutan: Pastikan data baru terus dikumpulkan dan diintegrasikan ke dalam sistem. Data baru ini harus mencerminkan tren dan perilaku pelanggan terkini.

- Evaluasi Berkelanjutan: Evaluasi model secara berkala menggunakan data terbaru. Lakukan evaluasi ulang untuk memastikan model tetap memenuhi standar kinerja yang diharapkan.

- Analisis Umpan Balik: Dapatkan umpan balik dari pengguna dan pemangku kepentingan lainnya. Umpan balik ini dapat memberikan wawasan berharga tentang kinerja model dan potensi masalah.

Strategi Menangani Model Drift dan Melakukan Retrain Model Secara Berkala

Model drift adalah masalah umum dalam ML. Untuk mengatasi model drift, diperlukan strategi yang efektif untuk mendeteksi, menganalisis, dan memperbaikinya. Retraining model secara berkala adalah kunci untuk menjaga akurasi model.

- Deteksi Drift: Gunakan metrik dan teknik yang telah disebutkan sebelumnya untuk mendeteksi data drift dan concept drift.

- Analisis Penyebab: Setelah drift terdeteksi, lakukan analisis untuk mengidentifikasi penyebabnya. Apakah ada perubahan dalam perilaku pelanggan, perubahan dalam data input, atau masalah lain?

- Retraining: Retrain model secara berkala menggunakan data terbaru. Frekuensi retraining tergantung pada laju perubahan data dan dampak drift pada kinerja model.

- Model Selection: Pertimbangkan untuk menggunakan beberapa model dan memilih model terbaik berdasarkan kinerja terbaru.

Praktik Terbaik untuk Monitoring Model

- Tetapkan metrik kinerja yang jelas dan terukur.

- Otomatisasi proses monitoring dan alerting.

- Lakukan analisis akar penyebab ketika masalah terdeteksi.

- Dokumentasikan semua perubahan pada model dan proses monitoring.

- Terus lakukan evaluasi dan perbaikan terhadap model dan proses monitoring.

Studi Kasus: Implementasi Machine Learning Pipeline

Implementasi machine learning pipeline untuk prediksi churn dan upsell telah terbukti efektif dalam berbagai industri. Mari kita telaah sebuah studi kasus nyata yang menggambarkan bagaimana pendekatan ini diterapkan, tantangan yang dihadapi, dan hasil yang dicapai.

Studi kasus ini akan memberikan gambaran komprehensif tentang bagaimana machine learning pipeline dapat memberikan dampak signifikan pada retensi pelanggan dan peningkatan pendapatan.

Deskripsi Proyek: Perusahaan Telekomunikasi XYZ

Perusahaan Telekomunikasi XYZ, penyedia layanan telekomunikasi terkemuka, menghadapi tantangan signifikan dalam hal churn pelanggan. Tingginya angka churn berdampak negatif pada pendapatan dan profitabilitas perusahaan. Selain itu, perusahaan ingin meningkatkan pendapatan dengan mengidentifikasi peluang upsell dan cross-sell yang tepat sasaran. Proyek ini bertujuan untuk mengembangkan dan mengimplementasikan machine learning pipeline untuk mengatasi kedua tantangan tersebut.

Arsitektur Machine Learning Pipeline

Arsitektur pipeline yang digunakan dalam studi kasus ini dirancang untuk memproses data pelanggan, membangun model prediksi, dan menghasilkan rekomendasi upsell. Berikut adalah diagram alur yang menggambarkan arsitektur pipeline tersebut:

- Pengumpulan Data: Data dikumpulkan dari berbagai sumber, termasuk data penggunaan layanan, informasi pelanggan, riwayat transaksi, dan data interaksi pelanggan dengan perusahaan (misalnya, panggilan ke pusat layanan, interaksi media sosial).

- Pembersihan dan Preprocessing Data: Data dibersihkan dari nilai yang hilang dan outlier. Dilakukan transformasi data, seperti penskalaan dan normalisasi, untuk memastikan kualitas data yang optimal.

- Ekstraksi Fitur: Fitur-fitur yang relevan diekstraksi dari data mentah. Fitur-fitur ini mencakup penggunaan layanan (misalnya, volume data yang digunakan, jumlah panggilan), demografi pelanggan, riwayat pembayaran, dan interaksi pelanggan.

- Pemilihan Model: Beberapa model machine learning diuji dan dievaluasi, termasuk algoritma seperti Logistic Regression, Random Forest, dan Gradient Boosting. Pemilihan model didasarkan pada kinerja prediksi pada data validasi.

- Pelatihan Model: Model yang dipilih dilatih menggunakan data pelatihan yang telah diproses.

- Evaluasi Model: Model dievaluasi menggunakan metrik seperti akurasi, presisi, recall, dan F1-score. Model yang memiliki kinerja terbaik dipilih untuk deployment.

- Deployment Model: Model yang telah dilatih dan dievaluasi di-deploy ke lingkungan produksi untuk prediksi churn dan rekomendasi upsell secara real-time.

- Pemantauan dan Umpan Balik: Kinerja model dipantau secara berkala. Umpan balik dari pengguna digunakan untuk terus meningkatkan model dan pipeline.

Tantangan yang Dihadapi dan Solusi

Proyek ini menghadapi beberapa tantangan utama:

- Kualitas Data: Data yang tidak lengkap, tidak konsisten, dan noisy.

- Solusi: Dilakukan pembersihan dan preprocessing data yang ekstensif, termasuk penanganan nilai yang hilang, deteksi dan penghapusan outlier, serta transformasi data.

- Pemilihan Fitur: Menemukan fitur-fitur yang paling relevan untuk prediksi churn dan upsell.

- Solusi: Dilakukan analisis fitur yang mendalam, termasuk penggunaan teknik seleksi fitur seperti Recursive Feature Elimination (RFE) dan analisis korelasi.

- Pemilihan Model: Memilih model yang tepat dengan kinerja terbaik.

- Solusi: Berbagai model dievaluasi, dan model yang memberikan kinerja terbaik pada data validasi dipilih.

- Integrasi: Mengintegrasikan pipeline dengan sistem yang ada.

- Solusi: Pengembangan API untuk memfasilitasi integrasi dengan sistem perusahaan yang ada.

Hasil yang Dicapai

Implementasi machine learning pipeline memberikan hasil yang signifikan:

- Penurunan Churn Rate: Terjadi penurunan churn rate sebesar 15% dalam enam bulan setelah implementasi.

- Peningkatan Pendapatan: Pendapatan meningkat sebesar 10% melalui rekomendasi upsell yang lebih efektif.

- Peningkatan Kepuasan Pelanggan: Rekomendasi upsell yang lebih relevan meningkatkan kepuasan pelanggan.

Pelajaran yang Dapat Dipetik

Studi kasus ini memberikan beberapa pelajaran penting untuk implementasi di masa depan:

- Kualitas Data: Kualitas data adalah kunci keberhasilan. Investasi dalam pembersihan dan preprocessing data sangat penting.

- Pemilihan Fitur: Seleksi fitur yang cermat dapat meningkatkan kinerja model.

- Pemilihan Model: Evaluasi berbagai model dan pilih model yang paling sesuai dengan kebutuhan.

- Pemantauan: Pemantauan terus-menerus terhadap kinerja model sangat penting untuk memastikan keefektifan jangka panjang.

- Kolaborasi: Kolaborasi yang erat antara tim data science dan pemangku kepentingan bisnis sangat penting untuk keberhasilan proyek.

Upselling: Strategi dan Personalisasi: Machine Learning Pipeline Yang Efektif Untuk Prediksi Churn Dan Mengidentifikasi Potensi Upsell Bagi Pelanggan.

Setelah berhasil memprediksi potensi churn pelanggan, langkah selanjutnya adalah mengambil tindakan proaktif untuk mempertahankan mereka dan meningkatkan nilai pelanggan. Salah satu strategi yang efektif adalah melalui upselling, yaitu menawarkan produk atau layanan yang lebih mahal atau memiliki fitur tambahan kepada pelanggan. Machine learning memainkan peran krusial dalam mengoptimalkan strategi upselling, memungkinkan perusahaan untuk menawarkan produk yang paling relevan dan meningkatkan kemungkinan konversi.

Strategi Upsell Berdasarkan Prediksi Churn

Prediksi churn menyediakan informasi berharga tentang perilaku dan kebutuhan pelanggan. Informasi ini dapat digunakan untuk merancang strategi upselling yang lebih efektif. Beberapa strategi upsell yang dapat disesuaikan berdasarkan hasil prediksi churn meliputi:

- Upselling Proaktif: Menawarkan peningkatan layanan atau fitur tambahan kepada pelanggan yang berisiko churn sebelum mereka memutuskan untuk berhenti. Tujuannya adalah untuk meningkatkan kepuasan pelanggan dan memperkuat ikatan dengan perusahaan.

- Upselling Reaktif: Menawarkan diskon atau insentif khusus untuk produk atau layanan yang lebih mahal kepada pelanggan yang telah menunjukkan tanda-tanda akan melakukan churn. Strategi ini bertujuan untuk meyakinkan pelanggan untuk tetap menggunakan layanan dengan menawarkan nilai tambah.

- Upselling Berbasis Nilai: Menawarkan produk atau layanan yang lebih mahal dengan menyoroti manfaat dan nilai yang lebih besar yang akan diterima pelanggan. Hal ini sangat efektif untuk pelanggan yang mencari solusi yang lebih komprehensif atau memiliki kebutuhan yang lebih kompleks.

- Upselling Berbasis Segmentasi: Mengelompokkan pelanggan berdasarkan profil, perilaku, dan prediksi churn, kemudian menawarkan penawaran upsell yang disesuaikan dengan setiap segmen. Pendekatan ini memastikan bahwa penawaran yang diberikan relevan dan menarik bagi setiap pelanggan.

Personalisasi Penawaran Upsell dengan Machine Learning

Machine learning memungkinkan personalisasi penawaran upsell secara efektif. Dengan menganalisis data pelanggan, model machine learning dapat memprediksi produk atau layanan mana yang paling mungkin diminati oleh pelanggan tertentu. Proses personalisasi melibatkan beberapa langkah:

- Pengumpulan Data: Mengumpulkan data pelanggan yang relevan, termasuk riwayat pembelian, perilaku penggunaan produk, demografi, dan interaksi dengan perusahaan.

- Analisis Data: Menggunakan algoritma machine learning untuk menganalisis data dan mengidentifikasi pola dan tren.

- Pembuatan Model: Membangun model machine learning untuk memprediksi produk atau layanan yang paling relevan untuk ditawarkan kepada setiap pelanggan.

- Personalisasi Penawaran: Menawarkan penawaran upsell yang dipersonalisasi kepada pelanggan berdasarkan prediksi model.

- Pengujian dan Optimasi: Terus menguji dan mengoptimalkan model machine learning untuk meningkatkan akurasi prediksi dan efektivitas penawaran upsell.

Contoh Identifikasi Produk atau Layanan Relevan

Machine learning dapat digunakan untuk mengidentifikasi produk atau layanan yang paling relevan untuk ditawarkan kepada pelanggan. Misalnya, sebuah perusahaan telekomunikasi dapat menggunakan machine learning untuk menganalisis data pelanggan dan mengidentifikasi pelanggan yang mungkin tertarik untuk meningkatkan paket data mereka. Model machine learning dapat mempertimbangkan faktor-faktor seperti:

- Penggunaan Data: Seberapa banyak data yang digunakan pelanggan setiap bulan.

- Jenis Perangkat: Jenis perangkat yang digunakan pelanggan (misalnya, smartphone, tablet).

- Lokasi: Lokasi pelanggan, yang dapat memengaruhi kebutuhan data mereka.

- Riwayat Pembelian: Riwayat pembelian pelanggan, termasuk produk atau layanan yang pernah mereka beli.

Berdasarkan analisis ini, model machine learning dapat memprediksi pelanggan mana yang paling mungkin tertarik untuk meningkatkan paket data mereka dan menawarkan penawaran yang dipersonalisasi, seperti diskon atau bonus data tambahan.

Alat dan Teknologi untuk Otomatisasi Upselling

Beberapa alat dan teknologi dapat digunakan untuk mengotomatisasi proses upselling:

- Platform CRM (Customer Relationship Management): Platform CRM seperti Salesforce atau HubSpot dapat digunakan untuk menyimpan data pelanggan, melacak interaksi, dan mengotomatisasi penawaran upsell.

- Platform Otomatisasi Pemasaran: Platform otomatisasi pemasaran seperti Marketo atau Pardot dapat digunakan untuk mengirimkan penawaran upsell yang dipersonalisasi melalui email, SMS, atau saluran lainnya.

- Algoritma Machine Learning: Algoritma machine learning seperti regresi logistik, pohon keputusan, atau jaringan saraf dapat digunakan untuk membangun model prediksi churn dan personalisasi penawaran upsell.

- API (Application Programming Interface): API dapat digunakan untuk mengintegrasikan model machine learning dengan platform CRM, platform otomatisasi pemasaran, dan sistem lainnya.

Etika dalam Melakukan Upselling

Penting untuk mempertimbangkan etika dalam melakukan upselling. Tujuan utama upselling adalah untuk meningkatkan nilai pelanggan, bukan untuk memaksa mereka membeli produk atau layanan yang tidak mereka butuhkan. Beberapa prinsip etika yang perlu diperhatikan:

- Transparansi: Harus jelas bagi pelanggan bahwa mereka sedang ditawari produk atau layanan yang lebih mahal.

- Relevansi: Penawaran upsell harus relevan dengan kebutuhan dan minat pelanggan.

- Nilai Tambah: Penawaran upsell harus memberikan nilai tambah bagi pelanggan, seperti fitur tambahan, manfaat yang lebih besar, atau penghematan biaya.

- Tidak Memaksa: Pelanggan harus memiliki kebebasan untuk menolak penawaran upsell tanpa merasa bersalah atau tertekan.

- Kepercayaan: Menjaga kepercayaan pelanggan sangat penting. Hindari praktik upselling yang agresif atau menipu.

Akhir Kata

Merancang dan mengimplementasikan machine learning pipeline untuk prediksi churn dan upsell bukanlah tugas yang mudah, namun imbalannya sangat besar. Dengan memanfaatkan kekuatan data dan teknologi, perusahaan dapat meningkatkan loyalitas pelanggan, meningkatkan pendapatan, dan mencapai pertumbuhan bisnis yang berkelanjutan. Ingatlah, kunci keberhasilan terletak pada pemahaman mendalam tentang data, pemilihan model yang tepat, serta strategi yang tepat sasaran. Dengan pendekatan yang tepat, machine learning pipeline dapat menjadi aset berharga dalam upaya mencapai keunggulan kompetitif.